Che cos’è l’AMI? Concetti e applicazioni

L’Intelligenza Artificiale Morale (AMI) si riferisce allo sviluppo di tecnologie intelligenti capaci di apprendere e applicare principi e valori morali. La ricerca nell’AMI esplora come le macchine possano essere dotate di capacità morali, come l’applicazione di giudizi sui conflitti di valore, l’apprendimento dall’esperienza, e la capacità di prendere decisioni morali. L’AMI si occupa di come le Intelligenze Artificiali (IA) possano essere utilizzate per affrontare e risolvere dilemmi etici, specialmente in contesti come la guida autonoma, dove possono emergere situazioni di vita o di morte. La sfida non è solo tecnica, ma anche filosofica e sociale, poiché richiede una riflessione su cosa consideriamo decisioni etiche e come queste possano essere integrate in sistemi automatizzati.

Limiti dell’AMI e critiche

García-Marzá e Calvo discutono delle sfide nell’emulare i giudizi morali complessi nell’IA. I sistemi AI attuali spesso si riducono a emulare decisioni morali basate su funzioni di utilità orientate agli obiettivi, piuttosto che su principi o norme etiche vere e proprie. Un altro punto importante sollevato è il deficit di motivazione emotiva nell’AMI, che rende difficile o persino impossibile progettare e sviluppare sistemi IA che comprendano e applichino la moralità in cui ha peso anche la componente emotiva.

Secondo García-Marzá e Calvo l’etica dilemmatica, su cui viene addestrata l’AMI, è inadeguata. Sostengono che se le decisioni morali sono ridotte a scelte tra opzioni estreme e binarie, si limita significativamente la comprensione e l’applicazione di una moralità più sfumata e complessa che caratterizza le decisioni morali umane. A causa dell’enfasi sui dilemmi, l’IA può portare a soluzioni e risposte che sono impraticabili nel contesto della realtà quotidiana. Le situazioni di vita reale sono raramente così nette e definite come i dilemmi morali classici utilizzati per addestrare queste IA.

In aggiunta, Pierpaolo Donati mette in luce una critica sostanziale all’attuale tendenza nell’IA, evidenziando come questa tecnologia sia prevalentemente concentrata sull’elaborazione di dati quantitativi e sulla razionalità computazionale. Secondo Donati, mentre l’IA eccelle nel trattare il quantitativo, manca di una vera competenza etica, che è intrinsecamente qualitativa e umana perché richiede la comprensione di valori, principi, empatia e contesti sociali e culturali.

Emerge che l’IA può essere programmata per identificare e reagire a situazioni che richiedono decisioni morali. Questo implica che l’IA può avere la “competenza” di riconoscere scenari etici e prendere decisioni basate su criteri prestabiliti, tuttavia, queste decisioni sono in gran parte il risultato di programmazione e algoritmi, piuttosto che di una comprensione intrinseca della moralità.

La moralità umana non è solo seguire regole o algoritmi, include la capacità di pensare criticamente, valutare contesti, comprendere e agire su principi etici che possono andare oltre le istruzioni programmate. La moralità umana implica la capacità di adattarsi, interpretare, e sfidare le norme morali esistenti in base a una comprensione profonda del contesto e delle circostanze. Questo livello di comprensione critica e adattabilità è qualcosa che l’IA attuale non possiede.

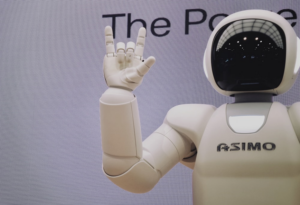

Foto di Possessed Photography su Unsplash

Le Leggi della Robotica di Asimov e il futuro dell’etica nell’IA

Mentre l’IA di per sé non può essere considerata morale in termini di consapevolezza o responsabilità, è possibile progettarla con regole e principi che guidino il suo comportamento in modi eticamente responsabili, seguendo esempi come le Leggi della Robotica di Asimov. Queste leggi, pur essendo nate nel contesto della fantascienza, hanno offerto una base per riflettere su come gli algoritmi e i sistemi IA possano essere progettati per agire in modi che rispettino alcuni standard etici. Le Leggi della Robotica di Asimov sono: (1) un robot non può recare danno a un essere umano o permettere, per inazione, che un essere umano subisca danno; (2) un robot deve obbedire agli ordini degli esseri umani, a meno che tali ordini non entrino in conflitto con la prima legge; (3) un robot deve proteggere la propria esistenza purché questa protezione non contrasti con la prima o la seconda legge. Sebbene queste leggi siano condivisibili, la loro interpretazione può portare ad ambiguità e, infatti, gran parte delle storie di robotica di Asimov nascono da ambiguità nell’interpretazione di queste leggi.

Se si esaminano dettagliatamente le proposte legislative e le linee guida etiche emergenti, che mirano a governare e guidare lo sviluppo dell’IA, si evidenzia il riferimento a undici principi fondamentali: giustizia e benessere, non-maleficienza, responsabilità, privacy, beneficenza, libertà e autonomia, fiducia, sostenibilità, dignità, solidarietà ed esplicabilità.

Questi principi forniscono un quadro per assicurare che l’IA operi in modi che siano non solo tecnicamente avanzati, ma anche allineati con valori umani fondamentali. L’importanza del principio di “esplicabilità” è particolarmente saliente, poiché sottolinea la necessità di trasparenza e comprensibilità nelle decisioni e nelle azioni dell’IA. In un mondo dove l’IA sta diventando sempre più influente nelle nostre vite, la capacità di comprendere e fidarsi delle decisioni prese da queste tecnologie è fondamentale, tuttavia sappiamo che è difficile ottenere una trasparenza completa nelle decisioni delle IA basate su reti neurali profonde, per questo ci troviamo a dover bilanciare l’efficienza dei risultati e la comprensibilità di questi. Attraverso la registrazione e l’analisi costante delle azioni dell’IA, si può verificare la conformità ai principi etici e alle normative, identificare e correggere eventuali bias o errori, e migliorare la fiducia degli utenti nelle decisioni dell’IA. Questo processo consente anche di perfezionare i modelli IA, garantendo che le loro prestazioni migliorino nel tempo in modo etico e sostenibile.

Collaborazione tra umanità e IA

Mentre è possibile programmare l’IA con regole che guidino il suo comportamento, esiste una distinzione fondamentale tra la capacità di un sistema di seguire regole etiche programmate e la capacità di esercitare un vero giudizio morale autonomo, che rimane una caratteristica umana. Non esistendo ancora una “coscienza artificiale” o una “saggezza artificiale”, l’IA non è ancora un agente morale. Tuttavia, come riporta Antonio Chella, ci sono numerose ricerche in corso per capire se e come sia possibile dotare le intelligenze artificiali di una forma di coscienza artificiale.

In conclusione, si può sottolineare che l’obiettivo non dovrebbe essere quello di creare sistemi autonomi che sostituiscano il giudizio e la moralità umana, ma piuttosto di sviluppare IA che amplifichino e arricchiscano la nostra comprensione. L’IA, infatti, dovrebbe essere vista come un partner collaborativo che lavora al fianco dell’umanità per raggiungere maggiori livelli di benessere, giustizia e comprensione reciproca.

Bibliografia

Asimov I., Robot, Gnome Press, New York 1950.

Chella A., Artificial consciousness: the missing ingredient for ethical AI?, in Frontiers, Volume 10 – 2023, 21 November 2023, https://doi.org/10.3389/frobt.2023.1270460

Donati P., Sociología relacional de lo humano, EUNSA, Barañain 2019.

García-Marzá D., Calvo P., Moral Learning by Algorithms: The Possibility of Developing Morally Intelligent Technology, in Algorithmic Democracy: Philosophy and Politics – Critical Explorations, Springer Nature Switzerland AG, 2024, pp. 103-122 https://doi.org/10.1007/978-3-031-53015-9_6

Foto di Lyman Hansel Gerona su Unsplash